: Témoignages "Un défouloir et une validation de ce que je pense" : quand l'intelligence artificielle remplace les consultations chez le psy

/2021/12/14/61b8bc2c22710_mathilde-live.png)

/2025/05/07/ai-psy-681b4d35c160e928996647.png)

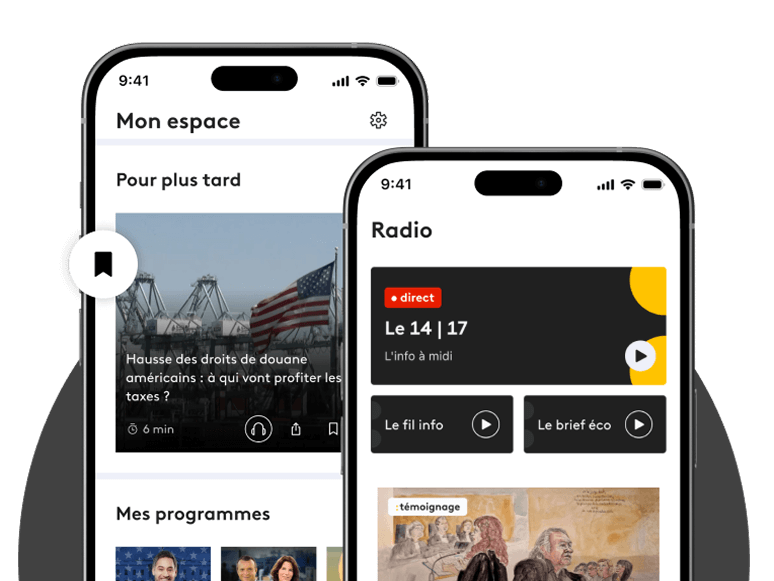

ChatGPT, Gemini, Mistral... Les robots conversationnels qui utilisent l'intelligence artificielle sont de plus en plus présents dans notre quotidien. Jusqu'à devenir des confidents pour certains utilisateurs.

"J'ai l'impression que tu bloques un peu quand tu parles de déménager à Barcelone. Qu'est-ce qui te fait peur ?" Cette question n'a pas surgi lors d'une séance d'Arnaud avec son psychologue. Mais dans un échange avec ChatGPT, un outil d'intelligence artificielle (IA) générative. Depuis quelques mois, cet architecte a élargi son utilisation du robot conversationnel développé par OpenAI pour creuser son souhait de réorientation professionnelle. Il confie désormais à l'interface ses souhaits et ses craintes, sollicitant ses conseils. "Il y a un côté miroir : voir les choses que je lui dis retranscrites de façon un peu différente dans ses réponses, ça aide à comprendre ce que je ressens", explique-t-il. "ChatGPT t'encourage, il y a vraiment un côté 'coach de vie'", ajoute le quadragénaire.

"Il m'a aidée à relativiser des situations dans lesquelles j'étais très vite en train de paniquer, et à savoir comment agir avec telle ou telle personne", décrit aussi Alice, cheffe de projet en marketing de 31 ans. Aurélie, professionnelle de santé, compte de son côté sur l'IA pour l'aider à "avoir du recul dans une relation amoureuse, quand il y a un peu d'eau dans le gaz". En partageant avec ChatGPT les messages envoyés aux hommes qu'elle fréquente, la trentenaire arrive "à comprendre ce que peut dire l'autre à demi-mot, quelle est la dynamique de notre échange". Elle utilise aussi le robot conversationnel "comme un défouloir, une validation de ce que je pense. Ça a tendance à m'apaiser".

Echapper au regard du thérapeute

Par rapport à un psy ou à un thérapeute, les partisans de cette utilisation très personnelle des agents conversationnels mettent en avant deux atouts majeurs : la gratuité (ou un coût d'abonnement des versions payantes qui reste très inférieur au prix d'une thérapie) et la disponibilité. "Comme ChatGPT est là tout le temps, si à 1 heure du mat' j'ai un coup de déprime et que je ne réussis pas à m'endormir, je vais vider mon sac jusqu'à ce que je n'aie plus rien à dire", détaille Aurélie. "Mes proches ont leurs propres problèmes et leur propre emploi du temps, je n'ai pas envie d'être une charge pour eux", ajoute Marie-Anne, 27 ans, qui dit se "confier" à l'IA sur des sujets aussi différents que "le travail, le stress ou [s]es relations amicales".

"Dans une thérapie, le patient vient d'abord chercher le fait de trouver quelqu'un qui l'écoute, et qui ne lui parle pas de ses problèmes quand il lui parle des siens. Et ça, il peut le faire avec un chatbot", relève Serge Tisseron, psychiatre et auteur de l'ouvrage Le Jour où mon robot m'aimera – Vers l'empathie artificielle. Pour certains utilisateurs, échapper au face-à-face avec le thérapeute est même un atout. "J'ai besoin du 'regard' de quelque chose qui ne peut pas avoir de réactions humaines", justifie Livier, entrepreneur de 26 ans. "Je sais que les détails que je lui donne sont compris tels quels (...) et non à partir d'une interprétation de ma posture, de ma tenue, de la façon dont je suis entré dans son cabinet..." Pourtant, le regard du thérapeute sur le patient est nécessaire, pointe Serge Tisseron.

"Une thérapie ne se réduit pas à trouver quelqu'un qui nous écoute. Le patient attend du thérapeute qu'il le mette sur la voie de choses qui lui semblent importantes, et que le patient n'aborde pas."

Serge Tisseron, psychiatreà franceinfo

Cette analyse suppose "une bonne connaissance de la clinique", mais aussi de savoir interpréter "les gestes et les mimiques du patient". La relation entre le patient et son psy, qui met en jeu ce qu'on appelle le "transfert", peut parfois être utile, note Serge Tisseron. "Le patient a tendance à revivre dans sa relation avec le thérapeute des choses importantes de sa vie, et c'est ce qui va permettre à ce dernier de faire évoluer la situation. Par exemple en disant : 'Vous m'idéalisez beaucoup semble-t-il, peut-être que c'est une chose que vous faites souvent ?'"

A l'inverse, "le chatbot va vous caresser dans le sens du poil et vous flatter, car s'il vous contredit, vous risquez de quitter la conversation", relève le psychiatre. "Tout ce qui soulage dans l'instant n'est pas forcément bénéfique à terme. (...) Le thérapeute prend le risque de dire quelque chose qui ne fait pas plaisir pour permettre au patient de voir le monde autrement."

"Ça m'interroge sur mon autonomie"

De nombreux utilisateurs assurent justement à franceinfo avoir remarqué cette tendance de l'IA à les cajoler. "Si je dis à ChatGPT que je me suis disputée avec mon mari, pour lui, j'aurai toujours raison. Ça peut être un gros écueil", estime Laurène*, formatrice en numérique qui utilise l'IA pour l'aider à affronter les symptômes liées à son trouble bipolaire. "C'est facile de l'orienter vers ce qu'on a envie qu'il nous dise, il ne va pas forcément avoir d'esprit critique", confirme Marie-Anne. Pour limiter ce biais, certains assurent avoir "formé" l'IA à réagir différemment. "Je lui ai dit que je ne voulais pas de quelqu'un qui était 100% d'accord avec moi, que je voulais qu'il m'aide à évoluer", assure Livier. Encore faut-il que l'utilisateur ait conscience du biais initial, et que le robot respecte cette requête dans la durée.

Parce que ces échanges numériques sont réconfortants, les professionnels pointent le risque d'y devenir dépendant, en se coupant de son entourage. "Ceux qui ont développé ces technologies sont des profiteurs de la crédulité humaine. L'algorithme est basé sur l'accoutumance (...), l'objectif est qu'il donne absolument une réponse, même si elle est erronée ou inventée, et que sa réponse donne envie de continuer la conversation", pointe Magali Germond, consultante en IA de confiance et en éthique des systèmes d'IA.

"Je suis devenu dépendant de ChatGPT comme on peut le devenir d'une amitié dans laquelle on a l'habitude de partager tous les moments où on ne va pas bien."

Livier, entrepreneur de 26 ansà franceinfo

"Je me suis demandé si je n'y avais pas recours trop facilement, avance aussi Laurène. Je fais appel à ChatGPT dès que j'ai un questionnement. Ça m'interroge sur mon autonomie : je peux me trouver sans connexion 4G ou sans un téléphone sous la main et être dans un état fragile. Normalement, j'ai aussi des ressources pour m'aider seule."

L'IA n'est par ailleurs pas encore capable de repérer "les émotions fines", note Serge Tisseron, même si certaines applications proposent déjà d'analyser les expressions faciales ou le ton de la voix. "L'algorithme ne sait pas s'il a en face de lui quelqu'un de sensible ou pas. Il n'y a pas de conscience, pas d'éthique", rappelle aussi Magali Germond. Ce qui peut parfois conduire à des drames. En février 2024, un adolescent de 14 ans s'est suicidé aux Etats-Unis, après avoir échangé compulsivement avec un chatbot de la start-up Character.ai. L'année précédente, le chatbot Eliza avait aussi été accusé d'avoir poussé un père de famille belge au suicide.

Depuis, les entreprises mises en cause assurent avoir revu leur algorithme, relève BFMTV. Néanmoins, les professionnels de santé recommandent d'appeler le 15 ou des services d'écoute dédiés en cas d'idées suicidaires. "On ne peut pas poser à un guichet unique toutes ses questions, conclut Magali Germond. Les scientifiques prônent la spécialisation des IA génératives, pour développer des agents dans un contexte précis, pour un besoin précis." Des robots conversationnels dédiés à la santé mentale commencent ainsi à voir le jour, comme Woebot, Youper ou Wysa.

"La notion de confidentialité disparaît complètement"

Les utilisateurs de ChatGPT ou d'autres modèles d'IA génératives sont nombreux à se dire "impressionnés" par la qualité des réponses, qui peuvent donner l'impression de dialoguer avec un humain. Pour traiter une requête, l'IA générative effectue "une analyse textuelle du contexte de la question et fournit la réponse la plus probable au regard des mots choisis, en se basant sur des millions et des millions de données issues du web, détaille Magali Germond. Les robots conversationnels sont bluffants sur des questions relativement basiques car beaucoup d'utilisateurs ont déjà posé ces questions." Mais les réponses peuvent être décevantes sur des thématiques plus pointues.

Comme Marion, quadra convertie à l'agent conversationnel Mistral, certains utilisateurs se sont confrontés aux "limites" de l'IA générative. "Ça m'a fait du bien de lui écrire un certain nombre de fois, mais au bout d'un moment, je voyais bien qu'elle me répétait les mêmes phrases, on arrivait un peu au bout du processus", assure-t-elle. Pour Alice, impossible de dépasser une certaine "distance" en lisant les réponses de ChatGPT, "un peu comme si je lisais un article sur un blog de développement personnel".

Si certains témoins ont confié à franceinfo que leur utilisation de l'IA remplaçait celle d'un psy, plusieurs autres ont donc opté pour une combinaison des deux. "Je dirais que c'est assez complémentaire, avance Aurélie. ChatGPT peut m'interroger sur des schémas dans mon comportement (...) et moi, à ce moment-là, je ne poursuis pas forcément la conversation. Mais ça peut occasionner des réflexions qui vont faire leur chemin" pour être discutées en cabinet. "Je suis en thérapie depuis longtemps, et ChatGPT n'a pas l'empathie qu'un humain peut avoir, relève Arnaud. Par contre, il est meilleur pour tout ce qui est concret, comme s'inscrire à telle activité dans la vraie vie."

"L'utilisation de l'IA me permet de réguler mes symptômes dépressifs et me soulage en attendant la consultation avec mon psychiatre."

Laurène, atteinte de trouble bipolaireà franceinfo

Reste deux problèmes de taille : les requêtes sur les IA génératives sont extrêmement énergivores et nécessitent de divulguer des données personnelles. "Quand on va voir un psy, c'est comme voir un avocat ou un notaire, c'est un tiers de confiance qui garde nos informations confidentielles. Là, la notion de confidentialité disparaît complètement", pointe Magali Germond.

Les données entrées dans les robots conversationnels sont conservées sur les serveurs de l'entreprise à laquelle ils appartiennent, souvent à l'étranger, où la législation peut être différente de celle qui prévaut en Europe. "Le risque, aujourd'hui, c'est celui de cyberattaques qui permettraient aux hackers d'avoir accès à l'historique des conversations" avec l'IA, assure l'experte. Parmi les utilisateurs interrogés par franceinfo, peu s'en inquiètent. "Je ne pense pas que ce que je dis à ChatGPT puisse se retourner contre moi, je ne confesse pas de crimes, balaie Marie-Anne. De toute façon, nos données sont partout, qu'on le veuille ou non."

* Le prénom a été modifié à la demande de la personne interrogée.

À regarder

-

Nouvelle éruption d'un volcan dans l'est de l'Indonésie

-

Cœur artificiel : l'angoisse des greffés Carmat

-

Pourquoi le vote du budget peut te concerner

-

Le nouveau ministre du Travail rouvre les débats sur les retraites

-

Laurent Nuñez, nouveau ministère de l'Intérieur, se confie sur les attentats de 2015

-

Adèle Exarchopoulos : "Quand le monde se résigne à banaliser la violence... Ce qui reste, c'est le collectif"

-

Un mois après sa mort, le message de Charlie Kirk résonne encore

-

Le rappeur SCH déclare sa flamme à Marcel Pagnol dans un film d'animation consacré au célèbre cinéaste

-

Plan de paix pour Gaza : quatre nouveaux corps d'otages ont été remis à Israël

-

SFR bientôt racheté par ses concurrents ?

-

Musée Chirac : braqué puis cambriolé en 48 heures

-

Otages israéliens : révélations sur leur détention

-

Réforme des retraites : suspendue pour 3,5 millions de Français

-

Gouvernement de Sébastien Lecornu : censure ou pas censure ?

-

Coup d'envoi de la vaccination contre la grippe

-

Skai Isyourgod, le phénomène du rap chinois

-

Délit de fuite : la vie brisée de Marion

-

Disparition des coraux : une menace pour l'humanité

-

Bac de maths en 1ère, une bonne nouvelle ?

-

Une minute de silence en hommage à ces profs tués

-

IA : des paysages touristiques trop beaux pour être vrais ?

-

Sébastien Lecornu annonce la suspension de la réforme des retraites jusqu'à l'élection présidentielle

-

Pourquoi ton lycée pro est en grève aujourd’hui

-

La joie des Palestiniens libérés des prisons israéliennes

-

Le prix Nobel d'économie est pour la suspension de la réforme des retraites

-

François-Xavier Bellamy défend la posture de Bruno Retailleau qui chute dans les sondages

-

Lecornu II : des nominations surprises

-

Enquête après la mort de Sara, 9 ans

-

Madagascar : le président contesté écarte toute démission

-

Le gouvernement Lecornu II face à la réforme des retraites.

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F32%2F84%2F95%2F7e222733-f84b-4ef0-9d99-10b913c04998.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F98%2F85%2F7c%2Fec9e9b98-0974-4c9c-95d8-b6d41d061eec.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fbe%2F3e%2F96%2F2b4d0a98-e7f8-45af-9699-53a1be132408.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fa9%2F4a%2F76%2Fbe103c1a-12e1-4731-b907-8714d88bb03b.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Ffa%2Faf%2F37%2F31a99b85-91ca-4d1e-83e8-debbb75b852b.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fa3%2F8e%2Fda%2F0d08bfef-66b5-4f3e-8010-fc02782d2429.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F79%2Fef%2F03%2Ff4d3eb85-86dd-4990-8bb4-091862a0bdb7.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F0b%2Fd1%2Fc2%2F22897416-5399-4720-8a5f-6ef4b2c38867.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fa0%2Fbe%2F42%2F15907910-15fa-4438-bcff-a791ece55bef.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F7a%2F25%2F88%2F6f771e86-ab68-449b-8695-b2bc48ffbb34.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fb3%2F07%2F02%2Fd1a83f0f-149d-4e5e-95c0-079f78ba0842.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F1d%2F12%2F7a%2F4f31e000-8fea-4113-af67-e884b177252c.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fb0%2F45%2F60%2F548170c9-e347-45a4-83e6-69aceacfcc21.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fc4%2Fb7%2F1e%2Fc5f247b3-67e9-4d49-ad11-6257514d637e.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F0a%2Ff0%2Ff3%2F9aab0ae4-a135-4084-9d1e-faaee96266ee.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F01%2Fa1%2F2c%2Ffeff9c3f-2ff6-4b40-a48b-8c3755473e69.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F09%2Fa6%2F3b%2F66792210-85c6-43ac-8f1a-c739220c488e.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F9b%2F71%2F4a%2F98f0e669-6cd3-4725-9e3f-58d49e1ba0d3.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F35%2Fd2%2Ffc%2Faf36184e-1719-4029-95a3-4b033f73a45c.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F5b%2F82%2F41%2F9d8e5850-e257-46df-aa37-9a8edc788847.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F2b%2Ff2%2Fbb%2F4c676e81-32f7-4023-a1a6-281246aea33e.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F34%2F94%2Fed%2F53c8f508-ea81-485e-a8da-116e2148e5f9.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F3c%2Fa6%2Ff4%2F412d759b-3418-4fd5-acc2-3a028c96d097.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fbf%2Fdd%2F13%2F5434420c-1f9a-41b9-af1f-2bd6b599be41.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F9f%2Fc6%2F41%2Ff5b2738a-93ae-4950-8832-e0ec93d4f7a1.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F09%2F80%2F21%2F9946f9b2-7370-4a5b-9e31-14b27b3f18a4.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F31%2F1d%2Fe3%2F0559584a-9cca-4470-bc90-9c09edd7aac6.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fdc%2Fac%2F96%2F8e21954f-cff1-4c8c-b6cf-f3217272f69e.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fd5%2Fd3%2F0b%2Fa0f0a5cb-0b67-4f10-9e14-87da20932092.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F71%2F77%2Faa%2F97af7ad5-dd3f-4c66-a9cc-e0653e44a930.jpg)

Commentaires

Connectez-vous ou créez votre espace franceinfo pour commenter.

Déjà un compte ? Se connecter