Si l'intelligence artificielle peut tout, comment éviter qu'elle fasse n'importe quoi ?

Tatouage pour distinguer les productions des IA des œuvres humaines, mesures de protection pour limiter les piratages et les hallucinations des algorithmes : les initiatives se multiplient pour encadrer le déploiement des intelligences artificielles.

/2024/09/14/nicolas-arpagian-66e5be37c179f515361798.png)

/2024/11/03/gettyimages-1969081867-67278d7ddf5fb766630988.jpg)

Photo, textes, vidéos, l’intelligence artificielle semble savoir tout faire. Comment peut-on savoir désormais, si l’auteur d'une de ces créations est un humain ? Il ne s’agit pas tant de savoir qui a conçu l’image ou la vidéo, que de savoir si celles-ci représentent des situations réelles, ou si elles sont uniquement le fruit d’un travail algorithmique.

C’est déterminant, par exemple, pour établir l’authenticité d’une prise de vue qui pourrait, si elle était fabriquée artificiellement, être utilisée à des fins de désinformation. C’est l’importance de la traçabilité d’une image ou d’un film. Pour identifier les deepfakes ou hypertrucage.

Un filigrane pour désigner les créations générées par une IA ?

On ne peut plus compter sur les "erreurs de jeunesse" de la technologie, qui ajoutaient un sixième doigt aux personnages, ou butaient sur la conception de jambes réalistes pour les humanoïdes numériques que l’on mettait en scène.

Aujourd’hui, les productions sont de plus en plus crédibles. Les équipes de l’entité DeepMind de Google ont publié fin octobre 2024 un article dans la revue scientifique Nature qui propose la piste d’un filigrane, la solution SynthID.

Il s'agirait d'intégrer un marquage, évidemment invisible à l’œil nu, dans toutes les productions émanant d’un modèle d’intelligence artificielle. Qu’il s’agisse de textes, d’images ou de séquences animées. L’idée étant que l’on puisse rechercher la présence de ce tatouage numérique, en cas de doute sur l’origine de la création.

Un marqueur qui reste contournable

À l’instar des antivols mis sur les vêtements dans un magasin, des techniques existeront toujours pour neutraliser ou effacer le dispositif. Par exemple, lors de l’analyse de textes. Il faut que le marquage résiste à des modifications délibérées, comme le remplacement de certains mots, de la paraphrase, voire des traductions. Les tests montrent une meilleure performance pour les textes longs et plutôt créatifs. L’outil serait moins efficace pour des sujets abordés de manière très factuelle et synthétique.

Cela confirme qu’il ne faut pas compter sur une seule technologie pour repérer les contenus problématiques. Et qu’il revient à chacun/e de conserver un regard critique et réfléchi sur les images, textes ou vidéos qui lui passent sous les yeux. Surtout si ces productions sont chargées en émotion, ou ont une portée politique. Il ne faut pas renoncer à l’intelligence humaine pour apprécier leur réalité et leur pertinence.

Des mesures de protection à intégrer dès la conception des modèles d’intelligence artificielle

Cette prise en compte originelle de la sécurisation vaut pour toutes les atteintes visant les Grands Modèles de Langage (en anglais LLM, pour Large Language Model). Ce sont ces mécanismes d'apprentissage automatique capables de comprendre des requêtes et de générer des contenus. Le Laboratoire d'Innovation Numérique (LINC) de la CNIL, la Commission Nationales Informatique et Libertés, a publié en octobre 2024 deux notes présentant les principales familles de risques en la matière.

Pour commencer, il y a le risque de régurgitation. Lorsque vous interrogez une IA et que celle-ci fournit dans ses réponses des données personnelles provenant des séances ayant servi à son entraînement préalable. De même, l’IA a pu recevoir pour consigne de générer un texte invitant l’utilisateur à communiquer des informations destinées à demeurer confidentielles. On comprend alors l’importance de soigner l’anonymisation des jeux de données servant à l’apprentissage des IA.

Il faut aussi anticiper la génération de réponses toxiques. Comme lorsque l'IA, par exemple, est sollicitée pour concevoir des contenus haineux ou violents. Ou pour élaborer des programmes informatiques malveillants.

Instaurer une culture de la sécurité

Les principales recommandations en matière de sécurisation ont été présentées dans un document établi avant l’été 2024, par l’Agence nationale de sécurité des systèmes d’information (ANSSI).

Elle rappelle l’importance de documenter l’ensemble des processus d’élaboration des modèles d’intelligence artificielle : de la qualité des informations utilisées en amont, à l’identification des personnes autorisées à intervenir sur les bibliothèques de données et les règles algorithmiques, jusqu’au contrôle des conditions de stockage, notamment dans le cloud, de l’ensemble de cette machinerie numérique.

Au-delà des seuls techniciens, il est souhaitable que le grand public, de plus en plus amené à manier ces outils d’IA, se familiarise avec ces principes de précaution. Alors que l’IA est appelée à jouer un rôle grandissant dans nos vies personnelles et professionnelles.

À regarder

-

Tempête "Benjamin" : des annulations de trains en cascade

-

Femme séquestrée : enfermée 5 ans dans un garage

-

Vaccin anti-Covid et cancer, le retour des antivax

-

A 14 ans, il a créé son propre pays

-

Ils piratent Pronote et finissent en prison

-

Aéroports régionaux : argent public pour jets privés

-

Bali : des inondations liées au surtourisme

-

Cambriolage au Louvre : une nacelle au cœur de l'enquête

-

Alpinisme : exploit français dans l'Himalaya

-

Un objet percute un Boeing 737 et blesse un pilote

-

Cambriolage au Louvre : où en est l'enquête ?

-

Jean-Yves Le Drian défend l'image de la France

-

Chine : 16 000 drones dans le ciel, un nouveau record du monde

-

Donald Trump lance de (très) grands travaux à la Maison Blanche

-

Glissement de terrain : des appartements envahis par la boue

-

Emmanuel Macron sème la confusion sur la réforme des retraites

-

Tornade meurtrière : scènes d'apocalypse dans le Val-d'Oise

-

Nicolas Sarkozy : premier jour en prison

-

La lutte sans relâche contre les chauffards

-

L'OMS alerte sur la résistances aux antibiotiques

-

Les frères Lebrun, du rêve à la réalité

-

Que disent les images de l'incarcération de Nicolas Sarkozy ?

-

Algospeak, le langage secret de TikTok

-

Une Russe de 18 ans en prison après avoir chanté des chants interdits dans la rue

-

Cambriolage au Louvre : d'importantes failles de sécurité

-

"Avec Arco, on rit, on pleure..."

-

Wemby est de retour (et il a grandi)

-

Arnaque aux placements : la bonne affaire était trop belle

-

Une tornade près de Paris, comment c'est possible ?

-

La taxe Zucman exclue du prochain budget

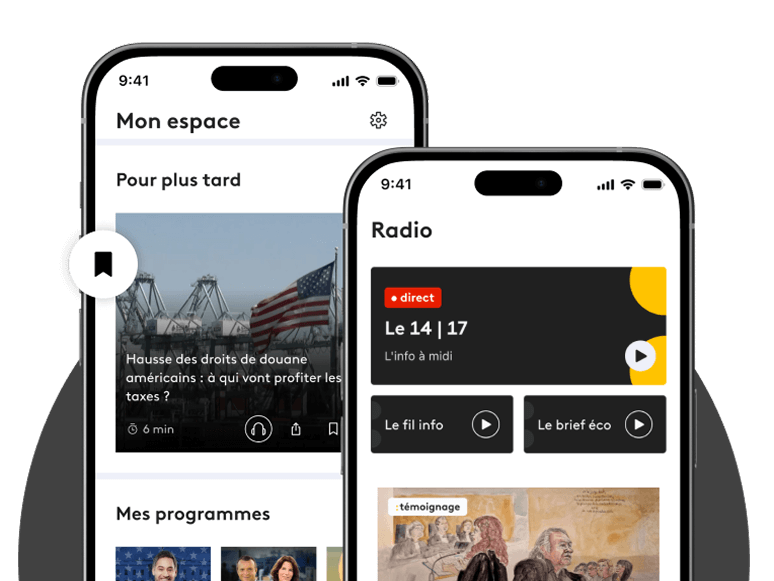

/https%3A%2F%2Fapi.radiofrance.fr%2Fv1%2Fservices%2Fembed%2Fimage%2F20b0887f-2e0b-43e1-a1a4-a37e10c30dfb%3Fpreset%3D400x400)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F84%2F4c%2F22%2F3d3f5c22-449e-4fdd-814c-a6588930da09.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F70%2F5a%2Fb7%2F4e0aefc4-c396-4cac-afe6-befefbe0eddd.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F43%2F15%2F71%2F4efa74b7-9005-4e58-9576-5d2a54ec6b68.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F78%2F1b%2Fc4%2Fa757b2b0-a45d-42ef-95ee-a225f891959d.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F16%2F6a%2F7b%2F7ba33535-2aaf-48df-8f35-0c993a56d7f8.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fed%2F0f%2F07%2F0c27db53-a325-446c-9743-39e4d90eafd5.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F18%2F54%2F3b%2Fe1a8abcb-ad98-441d-904d-fc6deadf56f6.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F68%2F96%2F35%2Feea67cd6-5430-4406-84b3-447916402bdc.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F03%2F74%2F6d%2F5d24080b-409f-48f1-8785-e173e7573cdd.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F55%2Fbd%2F65%2F4973d1ac-bcb4-4922-bb1b-ecc95905901f.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F39%2F89%2Fff%2F4099bcc0-be60-4afa-9eb9-0a830f96cab3.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fd9%2F8b%2F5a%2Fa4db6578-93a8-4901-90fe-7c34e8ef79fa.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F99%2Fbd%2F07%2F92c64dec-2080-4216-9840-c1c162327058.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fc4%2Fcf%2F15%2F6c7bfcce-ee0a-4482-99e6-b4557248c1d0.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F74%2F8c%2Fae%2Fe0ae705a-515c-474a-aed3-61fc3fcc6f09.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F59%2F95%2Fa0%2Fb18db24a-aa49-4785-9e41-95006dc9fddf.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F14%2Ff6%2F0a%2F22791259-1a74-488c-936f-48a91332c2ba.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fdf%2F40%2Fd9%2F8dd7b394-d611-4b2a-8672-d6bc81bdeeca.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Ff0%2Fa9%2F65%2F56aacfb2-265e-49e7-9943-5ed0e98056e7.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F8e%2Fa4%2F67%2F08ed7167-3a5d-4cc0-9e06-db0a8609ff06.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Faa%2F54%2Ff0%2F7d9cdd65-670a-43f0-ab96-a0267dbc1808.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F41%2Fb6%2F3d%2Fc440633e-cd38-4815-9f16-4db6565d7bd9.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F0f%2F51%2F1d%2F67dd7dfd-1825-42a0-a214-850be94e1ad5.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F68%2F5b%2F32%2Fca0347c7-58b0-4990-9d0a-9e5edb8b55e0.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fed%2F10%2Fa9%2Ff6270e52-b473-43c7-8901-6649908d1884.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fdd%2F2d%2F1c%2F623830c2-6ea5-4eed-9daf-fde57b894f2e.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F1a%2F1e%2F80%2Fe588bfda-e9e2-4c4f-b074-c9aca4b06db1.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F7e%2Fd9%2Ff7%2Ff955d854-39f4-4973-860a-77ba4702b776.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F3c%2F8f%2Ff2%2F43a7e4c1-c589-4fe3-af10-6c4ac9964734.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Feb%2F76%2Fc1%2F2d860025-013b-43e2-807e-a3630147eb35.jpg)

Commentaires

Connectez-vous ou créez votre espace franceinfo pour commenter.

Déjà un compte ? Se connecter