Un temps de correction des copies divisé par trois : quand l'IA vient à la rescousse des professeurs

De plus en plus d’enseignants adoptent l’IA pour faciliter la correction des copies, même si ces outils, qui promettent, gain de temps et impartialité, ne sont pas infaillibles.

/2024/03/04/anicet-mbida-65e601518a1e7410293503.png)

/2025/04/10/080-hl-lpierre-1309739-67f775383496c696645339.jpg)

Il n’y a pas que les étudiants qui utilisent l’intelligence artificielle pour leurs devoirs. Désormais, les professeurs aussi s’y mettent pour corriger les copies. Chaque semaine, un enseignant passe en moyenne plus de 6h30 en moyenne. Non seulement c’est chronophage, mais en plus, c’est répétitif, rébarbatif. Donc évidemment, on se dit que l’intelligence artificielle pourrait leur faire gagner du temps.

C’est pourquoi on voit arriver de plus en plus d’outils d’assistance à la correction des copies. Ils s’appellent Ed.ai, Examino, Gingo ou encore PyxiScience. Quasiment toutes les matières sont gérées, des maths aux dissertations. Ils promettent de diviser le temps de correction par trois, d’éliminer les biais et les erreurs liées à la fatigue. L’objectif étant d’arriver à une plus grande impartialité des évaluations.

Pas des correcteurs mais de simples assistants

Une fois la copie prise en photo ou scannée, elle passe à la moulinette de l’outil. Il va faire une pré-correction, une sorte de première passe que le professeur n’aura ensuite qu’à affiner ou à valider. Tous les critères sont fixés par l’enseignant : le barème de points, les consignes particulières à respecter et le type de réponse ou de mots clés attendus pour chaque question. Il ne s’agit pas de correction automatique. L’outil fonctionne simplement comme un assistant. L’enseignant garde tout le contrôle et toute la responsabilité de la note.

Mais il ne faut pas trop faire confiance à l'IA non plus car c’est malheureusement le principal travers des utilisateurs. Plus les résultats de l'IA sont bons, plus elle est efficace, et moins on a tendance à vérifier ce qu’elle produit. C’est comme cela que l’on se retrouve avec des rapports de recherche truffés d’erreurs dans les publications scientifiques ou des comptes-rendus d’avocats au tribunal qui inventent des faits. Sans oublier les problèmes classiques d’interprétation de l’écriture manuscrite. Parfois, les profs ont du mal à relire les élèves. Alors, imaginez une machine… On ne le répètera jamais assez : l’IA n’est pas aussi fiable qu’une calculatrice. On ne peut pas avoir une confiance aveugle. Il faut considérer ces outils pour ce qu’ils sont : des outils. Rien de plus.

À regarder

-

Cancer : des patientes de plus en plus jeunes

-

Cessez-le-feu à Gaza : un premier pas vers la paix

-

Quand t'as cours au milieu des arbres

-

Il gravit la tour Eiffel en VTT et en 12 min

-

Pourquoi on parle de Robert Badinter aujourd'hui ?

-

Robert Badinter : une vie de combats

-

La tombe de Robert Badinter profanée à Bagneux

-

Accord Hamas-Israël, la joie et l’espoir

-

"Qu’on rende universelle l'abolition de la peine de mort !"

-

Guerre à Gaza : Donald Trump annonce qu'Israël et le Hamas ont accepté la première phase de son plan

-

Les "MedBeds, ces lits médicalisés qui affolent les complotistes

-

Front en Ukraine : des robots au secours des blessés

-

Taylor Swift : la chanteuse de tous les records

-

Robert Badinter : le discours qui a changé leur vie

-

Nouveau Premier ministre, retraites : les temps forts de l'interview de Sébastien Lecornu

-

Lennart Monterlos, détenu en Iran depuis juin, a été libéré

-

Charlie Dalin : sa course pour la vie

-

La mère de Cédric Jubillar se dit rongée par la culpabilité

-

Le convoi du président de l'Équateur attaqué par des manifestants

-

Le discours de Robert Badinter pour l’abolition de la peine de mort en 1981

-

Pourquoi les frais bancaires sont de plus en plus chers ?

-

Oui, en trois ans, le coût de la vie a bien augmenté !

-

Pas de Pronote dans ce collège

-

Robert Badinter : une vie de combats

-

Disparition dans l'Orne : la petite fille retrouvée saine et sauve

-

"L’antisémitisme est devenu une mode", déplore Delphine Horvilleur

-

"Une pensée de l'espoir" nécessaire pour Delphine Horvilleur

-

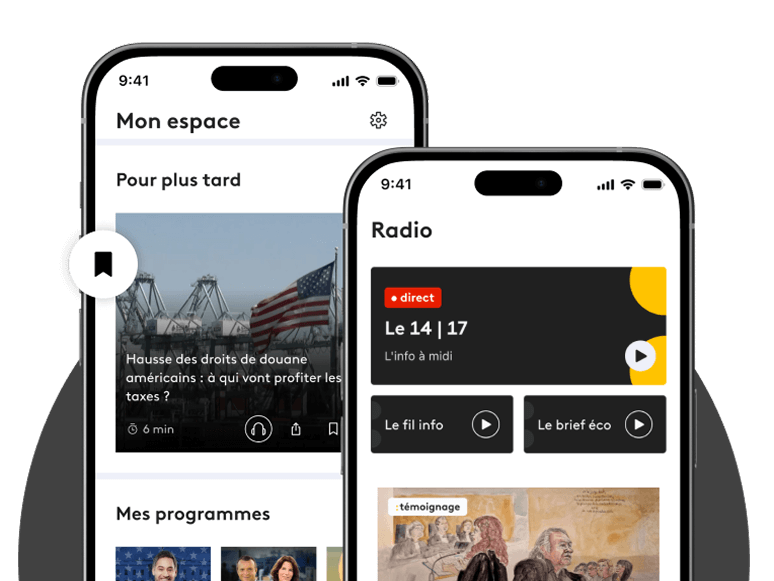

Ils ont le droit à l’IA en classe

-

"Il y a un monde politique qui est devenu dingue. Il est temps que ça s’arrête. Ça va rendre fou tout le monde"

-

Pouvoir d'achat : les conséquences d'une France sans budget

/https%3A%2F%2Fapi.radiofrance.fr%2Fv1%2Fservices%2Fembed%2Fimage%2F4b14746c-5dcb-4a38-87ef-049cc960f62d%3Fpreset%3D400x400)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fcf%2F22%2F70%2F6ff264a7-7864-4826-8297-70f692a49f19.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F94%2Fa2%2Ff7%2F66708f9d-5693-4cbd-93cb-ef8085ed6adc.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F46%2Fa6%2F00%2F609b8fee-76b2-4961-b0d7-c34343ddb8d6.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F9a%2F82%2Fa7%2Fcae8e340-d76e-4a87-bf64-a71b835d8950.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Ff9%2F75%2Fe5%2Ff6429b61-25ea-4e2d-8a0b-8d1404b69c65.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fec%2F71%2Fd5%2F8634e647-e178-47be-a944-547a64d48ebe.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F16%2Fb7%2F8a%2F39a82886-cf41-47d9-9124-c789c626a8bc.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F0f%2F6a%2Fb0%2F7f44ac6e-8398-4d80-8f28-990aa5e74886.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F39%2F13%2Fdc%2Fef703d43-3a76-47d6-9a44-6af0dce3ae08.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F08%2Fc4%2F64%2Fe41985c8-2844-4fde-856b-d35e0ec1c470.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F8a%2Fbf%2F8e%2Ff2c7fed0-9756-43db-876a-893e4a71f18f.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F9b%2F34%2Fca%2F0fa31d59-5624-46ce-963e-7d1a78f15963.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F3a%2Fce%2Fd6%2F5d782727-e7b3-418c-8453-88aa08f023dd.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F73%2F82%2F49%2F15337da5-7caf-43c6-91e3-0dfe523b0a2d.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F14%2F0c%2F31%2Fc6f74cfa-5635-4d1f-b9fb-9ac08687ec64.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F5e%2F8e%2F0f%2Ff541f090-5113-4a8f-a047-3df40fdb475b.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F1a%2F8b%2F51%2Fb8c22ed8-e219-4b42-a641-ba3a8cccfdbb.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F4f%2F9a%2Fe1%2F6b8d55ef-e1ee-45f5-8cfb-c6222150c0c7.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Ff5%2F01%2F99%2Fd0b02682-6c1e-4feb-b5ae-fdd8f019cb67.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F41%2F15%2F7d%2Fa2c580f2-083a-4362-a779-d2f16bd784d4.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F6a%2F10%2F58%2Fdb81743d-5ca4-4eee-acb4-d44beecd579c.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F4a%2F15%2F78%2Ffa40d581-4e93-48bc-9ef1-88d21a13c1f1.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fc9%2F9a%2F8f%2Fefe0f3b6-6232-4969-af35-99552930aa2d.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fec%2F71%2Fd5%2Fcbf7b61a-fb0d-4fcc-84e5-d9f91eadb942.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F4d%2Fff%2F48%2F35c9c4ee-b84b-4e28-b74f-4d4e692e90ad.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F95%2F07%2Fff%2F5e2773fa-e171-46f2-bf5d-ec453c0633ae.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F64%2F43%2F77%2F8c9f72e6-7f7f-41f5-9171-452a0fa40175.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F3c%2Fd7%2F02%2Fc514e603-fff7-4848-a206-f94f20e16892.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F6a%2F06%2Fd2%2F4547507c-8e54-4712-afa5-b28eb9f62983.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fa1%2Fd7%2F9f%2F09ebb9cb-3cc0-4d85-b447-cb4bbb6c151c.jpg)

Commentaires

Connectez-vous ou créez votre espace franceinfo pour commenter.

Déjà un compte ? Se connecter